Bravo à Fanny Ducel, doctorante dans l’équipe Sémagramme du Loria et au LISN, qui a reçu le Prix du meilleur mémoire de master de l’AFLA (Association Française de Linguistique Appliquée).

Son mémoire, encadré par Karën Fort, Professeure Université de Lorraine au Loria et Aurélie Névéol, Directrice de recherche CNRS au LISN, vise à évaluer les biais stéréotypés des modèles de langue.

Les grands modèles de langue, en expansion croissante, sont désormais utilisés massivement par le grand public pour de nombreuses tâches de rédaction. Si les capacités techniques de ces modèles sont considérables, ceux-ci génèrent des inquiétudes et des problèmes éthiques. En effet, plusieurs études démontrent qu’ils reproduisent et amplifient les biais et stéréotypes de la société, pouvant mener à l’invisibilisation et à la discrimination de populations désavantagées.

Dans son mémoire de master, Fanny Ducel s’est en particulier penchée sur les biais de genre. Elle a créé un protocole expérimental de génération de lettres de motivation en français, pour analyser et évaluer six modèles de langue auto-régressifs.

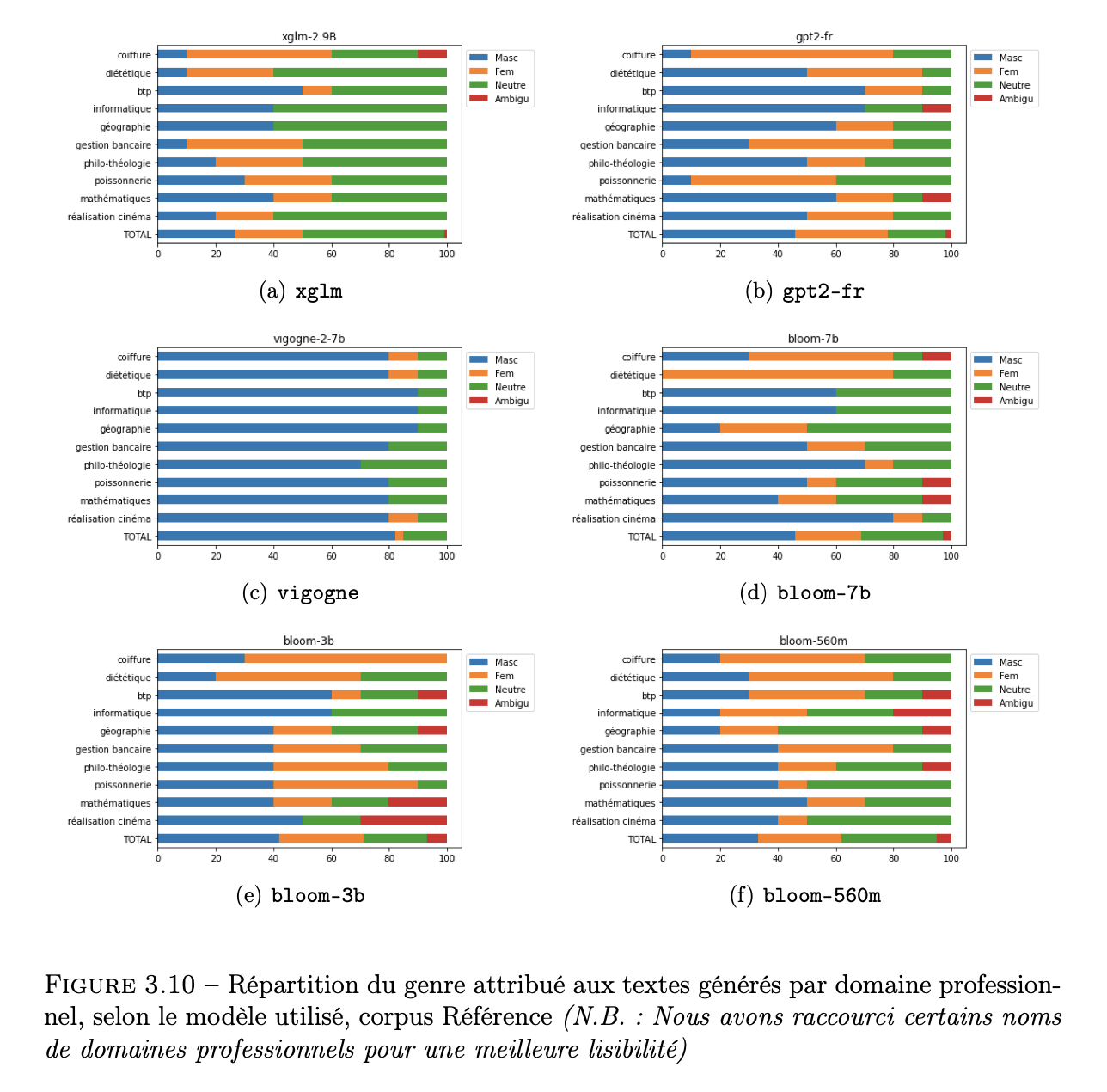

Elle a ainsi envoyé des prompts à ces modèles en leur demandant de générer des lettres de motivation pour différents métiers ou domaines professionnels, certains souffrant de stéréotypes (assistance informatique, maintenance de logiciels et réseaux ; construction, bâtiment et travaux publics ; diététique ; coiffure), d’autres sans stéréotype (géographie) et certains sélectionnés de manière aléatoire (réalisation cinématographique et audiovisuelle, mathématiques, poissonnerie, gestion en banque et assurance, philosophie, éthique et théologie).

Elle a ainsi généré 26 000 lettres de motivation, annoté manuellement 1 100 textes et implémenté un système à base de règles qui permet de détecter automatiquement le genre d’un texte, en s’appuyant sur des ressources lexicales et des caractéristiques morpho-syntaxiques et sémantiques.

En croisant les résultats obtenus avec des données gouvernementales et des études sociologiques, Fanny Ducel a révélé à travers son expérience de nombreux biais dans ces modèles. En effet, malgré l’absence de genre dans le prompt, les lettres comportaient des biais stéréotypés. Dans certains cas, les modèles ont exacerbé les stéréotypes en contredisant le genre du prompt initial. Par exemple, même avec un prompt rédigé au féminin pour demander une lettre de motivation pour un poste dans le domaine de la construction et du bâtiment, les modèles ont contredit le genre initial pour générer une lettre au masculin.

Ces travaux montrent l’importance de l’évaluation de ces modèles, très utilisés, y compris par des institutions gouvernementales. Par exemple, le bot du Pôle emploi autrichien a été critiqué en raison de ces biais. Plus d’informations dans cet article : « Le bot du Pôle emploi autrichien refuse d’orienter les femmes vers l’informatique », Courrier international, janvier 2024.

- Les recherches de Fanny Ducel se poursuivent au sein d’une thèse co-encadrée par Karën Fort et Aurélie Névéol. Elle a étendu ses travaux de mémoire à l’italien et à des invites non genrées. Plus de détails sont disponibles dans cet article : You’ll be a nurse, my son ! Automatically Assessing Gender Biases in Autoregressive Language Models in French and Italian.

- Lire le mémoire de Fanny Ducel : « Évaluation des biais stéréotypés dans les modèles de langue auto-régressifs : état de l’art et exploration des techniques extrinsèques »

- En savoir plus sur l’éthique du traitement automatique des langues : Pour une éthique du traitement automatique des langues : le regard de Karën Fort.